Capítulo 11 Prueba de hipótesis: la lógica

En este capítulo ingresamos a uno de los procedimientos de mayor difusión en investigación cuantitativa: la prueba de hipótesis, que se en los mismos principios de estimación de parámetros que fundamentan la construcción de intervalos de confianza, por lo que su objetivo también es hacer uso de resultados muestrales para obtener conocimiento acerca de la población. Este procedimiento no está exento de críticas Greenland (2019); sin embargo es básico para hacer inferencias sobre la población y conserva amplia difusión tanto en ciencias sociales como naturales, (Halsey 2019). Las propuestas que existen como técnicas alternativas que superan las falencias que acusan sus críticos (Goedhart 2018), requieren que se tenga dominio de las pruebas de hipótesis.

11.1 El razonamiento de la prueba de hipótesis

La prueba de hipótesis tiene como objetivo el de proveer argumentos para decidir en contextos de incertidumbre. A partir de lo que sabemos sobre las distribuciones en el muestreo, ése es el caso cuando necesitamos concluir acerca de una población, a partir de información que tenemos disponible en una muestra aleatoria. El resultado de la prueba permitirá decidir si lo que se observa en la muestra es compatible con una aseveración hipotética sobre la población. Nunca será posible decidir de manera taxativa que la hipótesis es verdadera, eso es algo que no podemos saber; por el contrario, podemos ver hasta qué punto lo que observamos en la muestra contradice -o no- lo que se afirma a escala poblacional. Es decir que podremos descartar una hipótesis por no ser compatible con lo que se observa, pero no a la inversa: no será posible “confirmar” una hipótesis, solo podremos concluir que la evidencia no la contradice, lo que también se expresa diciendo que no hay evidencia para rechazarla.

Empezaremos con ejemplos no muy cercanos a la investigación social cuantitativa, para mostrar que esta forma de razonar no es ajena a lo cotidiano. Una prueba de hipótesis puede compararse con un juicio penal: la persona acusada no es condenada hasta que no hay evidencia suficiente para hacerlo. La evidencia (las pruebas, en el lenguaje de la justicia) rara vez son completas, se trata de información fragmentada, sujeta a interpretaciones diferentes. En el inicio del juicio, “la persona acusada es inocente”, en nuestra notación llamaremos a esa afirmación, hipótesis nula, y la indicaremos . Esta expresión indica que se trata de un estado inicial: toda persona es inocente hasta que se prueba lo contrario, por lo que la hipótesis nula señala que esta persona en particular (la acusada), no es diferente de cualquiera que no ha cometido delito. Mientras no haya pruebas suficientes, la hipótesis nula se considerará aceptada. En el juicio, la fiscalía aportará pruebas en dirección contraria a esta hipótesis. Buscará información para probar que debe rechazarse la hipótesis nula y condenar a la persona acusada. Difícilmente estarán a la vista todos los datos necesarios para reconstruir la situación y dar una respuesta absolutamente inequívoca, pero si hay suficiente evidencia, se dará la hipótesis nula por rechazada. La decisión de condenar a la persona acusada solo se tomará cuando haya muy poco riesgo de equivocarse, cuando la probabilidad de decidir de manera errada sea muy pequeña.

En este ejemplo, la población es el conjunto completo de información necesaria para tomar la decisión de manera certera, sin error. Se trataría de un conjunto infinito de datos que permitiría la reconstrucción exacta de los hechos en los que participó la persona acusada. Por cierto, esa información nunca está disponible, por lo que la decisión debe tomarse a partir de un fragmento de ella, que son las pruebas que han podido reunirse (la evidencia). En la analogía que hacemos con nuestros procedimientos, esta evidencia constituye la muestra a partir de la que se juzgará la hipótesis nula: rechazarla o no rechazarla. La muestra constituye el fragmento de información disponible, solo que en el caso de la estimación, ésta es obtenida con procedimientos que buscan su representatividad.

Otro ejemplo: tenemos dudas sobre lo equilibrada que pueda estar una

moneda que va a usarse en un juego de azar. Repitiendo la notación del

ejemplo anterior, formularemos una hipótesis nula que dice que X sale

con la misma frecuencia que C, que equivale a decir que hasta que no se

pruebe lo contrario, X no tiene ninguna diferencia con C, la moneda está

equilibrada. Esta hipótesis nula puede escribirse de manera formal,

porque “salir con la misma frecuencia que C” equivale a decir que, “en

infinitas tiradas, la mitad de la veces saldrá X”, por lo que

escribiremos nuestra hipótesis nula así: , a la que leeremos

“la hipótesis nula afirma que la proporción de veces que saldrá cara es

1/2”. Como no es posible arrojar la moneda infinitas veces, generamos un conjunto de datos para hacer la prueba, tirando al moneda un número finito de veces, digamos cien veces, esa es la muestra de tiradas.

Al arrojarla 100 veces esperaríamos -si la hipótesis nula se sostiene-, que

salga aproximadamente 50 veces X. Las 100 tiradas son una muestra de las

infinitas tiradas de la moneda, por lo que posiblemente no salga

exactamente 50 veces X, podría salir 51 veces ó 52 y serían resultados

esperables, debido a fluctuaciones propias del azar. Pero si de las 100

tiradas sale 80 veces X, concluiremos con pocas dudas que hay que

rechazar la hipótesis nula. A la misma conclusión llegaríamos si, de 100

tiradas, solo sale 25 veces X. La pregunta que nos ayudará a responder

el procedimiento de prueba de hipótesis es ¿cuántas más o menos veces

que 50 debería salir X para que consideremos que tenemos “suficiente

evidencia”, para creer que la moneda no está equilibrada?

La lógica de la prueba de hipótesis consiste en plantear el escenario en el que es verdadera y observar cuán probable es lo que hallamos en la muestra en ese caso. En el primer ejemplo el planteo es ¿cuán probable sería haber hallado estas pruebas (la evidencia) contra la persona acusada, si ésta fuera inocente? En el segundo preguntamos ¿cuán probable habría sido hallar esta cantidad de veces que salió , si la moneda estuviera equilibrada? De manera general la pregunta es ¿cuán probable sería éste resultado muestral si la hipótesis nula fuera cierta?

Si la respuesta a esas preguntas es “muy probable”, la decisión será la de no rechazar la hipótesis nula, porque los resultados muestrales hallados serían esperables (muy probables) bajo . Al contrario, si la respuesta es “muy poco probable” decidiremos rechazar , ya que se trata de un resultado poco esperable si fuera cierta.

En investigación, la prueba de hipótesis suele formularse de tal modo que rechazar implica aportar un nuevo hallazgo, por el contrario, no rechazar equivale a que no hay cambios respecto de alguna situación inicial.

Algunos ejemplos de hipótesis nulas:

Esta droga no produce ningún efecto sobre la memoria.

La técnica terapéutica A es igualmente eficaz que la B.

Los métodos A y B para enseñar a leer en la escuela primaria producen iguales resultados.

La proporción de votos que obtendrá un partido politico no ha variado respecto de las últimas elecciones.

Un programa de potabilización de agua no reduce la diarrea infantil.

La edad no hace diferencia en las orientaciones políticas de las personas.

Un plan de capacitación para madres que se ha implementado no tiene efecto en el desarrollo de sus hijas o hijos.

En casi todos los casos, la expectativa de la investigación está en rechazar la , porque eso significa que se ha hallado algo de interés: que la droga produce efectos, que hay técnicas terapéuticas mejores que otras y por tanto recomendables, que se pueden elegir mejores métodos para enseñar a leer, que el favor del electorado hacia un partido político es más o menos extendido, que el programa de potabilización mejoró la salud infantil, que la edad es un factor explicativo de las diferencias ideológicas, que el plan de capacitación impactó (positivamente).

| La hipótesis nula es una afirmación sobre un parámetro que indica ausencia de diferencia en relación a cierto valor de referencia. |

El sentido de esa diferencia difiere según el tipo de prueba, veremos que hay pruebas que confrontan con valores históricos o con promedios generales o bien que realizan comparaciones entre grupos. En todos los casos la hipótesis nula afirma algo que puede expresarse como “no hay diferencia”, o “no hay cambio” o “no hay relación”.

Hasta este punto se trata de la definición original de estas pruebas, desarrolladas inicialmente por Sir Ronald Fisher (1925) a las que llamó pruebas de significación. La idea básica es la de comparar los datos observados con la hipótesis que se pone a prueba. Fisher las ideó como manera de medir el grado de incompatibilidad de un conjunto de datos con la hipótesis nula, evaluando la probabilidad de hallar resultados como los observados o más extremos, si la hipótesis nula fuera cierta. Si esa probabilidad es muy pequeña, puede suceder que la muestra que se seleccionó haya sido excepcional, o bien que la afirmación hipotética sea falsa. Fisher argumentó que se trataba de un método objetivo para poner a prueba teorías y que puede ser usado en diferentes campos de conocimiento.

Con posterioridad a Fisher, Neyman and Pearson (1928) introducen dos cambios importantes en el procedimiento.

El primero consiste en tratar a las prueba no ya como métodos para validar teorías, sino como reglas de decisión, es decir, criterios que permiten decidir en las situaciones en que no se cuenta con toda la información necesaria.

El segundo cambio consiste en oponer a la hipótesis nula, otra hipótesis, llamada hipótesis alternativa, a la que se indica como , que es hacia la que se suma evidencia cuando se rechaza .

Veamos la aplicación de este modelo, que es el que usaremos a partir de ahora. La afirmación “los niños y las niñas que provienen de hogares con alto nivel de educación tienen rendimiento en la escuela superior al promedio general” es una hipótesis, porque pretende tener carácter general, hace referencia a la población de quienes están en la escuela, quienes asisten ahora y quienes asistirán en el futuro; no podemos observar a la población completa, por lo tanto la hipótesis no puede probarse de manera definitiva, solo puede hacerse a partir de una muestra. Para formalizar esa hipótesis, construiremos una que niegue cualquier diferencia: “el rendimiento de los niños y las niñas que provienen de hogares de alto nivel educativo es el mismo que el del promedio”. A esta hipótesis, opondremos otra, que afirme “los niños y las niñas que provienen de hogares de alto nivel educativo tienen rendimiento superior al promedio”. A esta última llamaremos hipótesis alternativa, . Así formalizamos el planteo del problema.

Supongamos ahora que conocemos ese rendimiento promedio, medido por el puntaje en las pruebas y que vale 60 puntos para la población completa de estudiantes, de un nivel determinado al que se acota la investigación. De modo que podemos formular las hipótesis ahora así:

: “El rendimiento promedio de los niños y las niñas que provienen de hogares de alto nivel educativo es de 60 puntos”

: “El rendimiento promedio de los niños y las niñas que provienen de hogares de alto nivel educativo es superior a 60 puntos”

Para poner a prueba la hipótesis tomaremos una muestra de niños y niñas que provienen de hogares de alto nivel educativo y veremos si su rendimiento es superior a 60 puntos. Supongamos que en la muestra hallamos una media de 62 puntos, ¿hay razón suficiente para rechazar la ? La respuesta no es inmediata, porque, si bien 62 es mayor que 60, una diferencia de solo 2 puntos parece demasiado pequeña y podríamos atribuirla al azar. Aquí nos interesa evaluar la probabilidad de ocurrencia del resultado que se observa, si la hipótesis nula fuera cierta. En este caso será: “Si quienes provienen de familias con alto nivel de educación tuvieran el mismo rendimiento que el promedio ( verdadera), entonces una diferencia de 2 puntos en el promedio muestral es probable, es esperable, puede deberse a la variabilidad propia de los datos muestrales. En consecuencia, esa diferencia no es suficiente para rechazar la ”. En otros términos: “Si quienes vienen de familias con mucha educación tuvieran un rendimiento promedio de 60 puntos, no sería de extrañar que una muestra arroje un resultado de 62 puntos”. Dicho de otro modo: el resultado muestral no se aleja tanto de lo que esperaríamos si la fuera cierta, por lo tanto, no podemos rechazarla y concluimos que los niños y las niñas que provienen de hogares de alto nivel educativo no difieren en su rendimiento escolar del promedio general.

Un elemento de mucha importancia es recordar que la hipótesis hace referencia a la población, mientras que la información disponible es muestral, y sabemos que los resultados muestrales difieren de los valores paramétricos porque son variables aleatorias.

¿Qué habría sucedido si hubiésemos observado que el grupo de quienes vienen de familias muy educadas tiene un rendimiento promedio de 95 puntos? Este resultado se aleja mucho de 60 que es el que sostiene , es decir, si el hipotético fuera verdadero, sería muy poco probable hallar una muestra que promedie 95 puntos. En consecuencia seguramente rechazaríamos la .

Al realizar pruebas de hipótesis, en lugar de evaluar intuitivamente si un valor muestral está cerca o lejos del valor hipotético, lo que haremos será evaluar cuál sería la probabilidad de hallarlo si fuera cierta la hipótesis nula. Cuando esta probabilidad sea grande no habrá evidencia para rechazarla, cuando sea pequeña decidiremos rechazarla. ¿Cuán grande o pequeña? Es de lo que nos ocuparemos a continuación.

Para realizar una prueba de hipótesis, necesitamos calcular la probabilidad del valor observado, si fuera cierta, es decir, si el parámetro tuviera ese valor (el que señala ). Es una probabilidad condicional que podemos por ahora escribir así:

Luego haremos más precisa esta expresión.

Comenzaremos con el ejemplo de una prueba de hipótesis sobre la media de una variable cuantitativa y luego acerca de la proporción para una categoría de una variable nominal.

11.2 Prueba sobre la media

Ejemplo (datos ficticios): para una determinada carrera universitaria, el tiempo promedio para completarla ha sido, históricamente, de 7.30 años. Decimos históricamente para indicar que son datos acumulados por largo tiempo y que provienen de los registros de la facultad de años atrás. Se ha introducido un cambio en el plan de estudios de la carrera y puede creerse que con esa modificación, el tiempo para terminar la carrera haya cambiado. Tenemos entonces un promedio de la población de quienes se recibieron en las anteriores condiciones, es una media poblacional porque describe al conjunto completo de quienes se recibieron con ese plan, que ya caducó. El objetivo es hacer inferencia sobre la media poblacional de quienes cursan con el nuevo plan, que no son totalmente accesibles, porque hay quienes están cursando y quienes lo harán en el futuro (porque el nuevo plan seguirá vigente durante los próximos años), por lo que de esa población solo puede conocerse a una muestra de quienes ya han egresado y ver cuánto tiempo han tardado en terminar la carrera.

La hipótesis nula es:

A la que oponemos una hipótesis alternativa:

La hipótesis nula indica que la media poblacional de quienes cursan con el nuevo plan es la misma que antes, que no hay diferencia, que no hay cambios. La hipótesis alternativa afirma lo contrario: que el tiempo promedio que tardan en terminar la carrera quienes la cursan con el nuevo plan es diferente a los 7.30 años históricos. No anticipamos si aumentó o disminuyó el tiempo para recibirse, solo que no es el mismo que con el plan viejo.

Ambas son afirmaciones sobre la población (sobre el parámetro media poblacional), por eso son hipótesis.

Si la hipótesis nula fuera cierta, por lo que sabemos sobre las distribuciones en el muestreo, la siguiente sería la distribución de las medias muestrales:

Figura 11.1: Distribución de las medias muestrales bajo la hipótesis nula

La campana está centrada en la media hipotética, que es el escenario en el que es verdadera. La probabilidad que la curva asigna a los diferentes valores de , quiere decir que “lo más probable” sería hallar a la media muestral (la única que tendremos como dato) alrededor de 7.30. Hay poca probabilidad de encontrar valores muy lejanos a 7.30, como lo muestran las áreas decrecientes, a medida que nos alejamos de la media hipotética. Por esta razón, para decidir si un resultado muestral se aleja mucho o poco del valor paramétrico, deberemos determinar si es poco probable o muy probable. Será equivalente decir que un valor se aleja mucho de la media hipotética que decir que se trataría de un valor poco probable, si la media fuera la que propone la .

| Afirmar que un valor muestral se aleja mucho del valor poblacional equivale a decir que sería muy poco probable si el valor poblacional fuera el hipotético. |

A fin de realizar la prueba de hipótesis debemos obtener una muestra. Supongamos que seleccionamos 100 personas que han terminado la carrera (usando un muestreo irrestricto aleatorio) y que encontramos un tiempo promedio ha sido de 7.50 años con una desviación estándar de 1.30 años ( y ). Debemos tener un criterio para decidir si este valor observado es compatible con la hipótesis nula () o si constituye evidencia suficiente para rechazarla en favor de la hipótesis alternativa (). El criterio es el de ver cuán probable sería este valor observado si la hipótesis nula fuera cierta. En consecuencia, debemos calcular la probabilidad que tiene de asumir el valor observado. Sin embargo, no es posible hallar probabilidades para valores únicos de una variable continua, por lo que buscaremos la probabilidad de hallar valores como el observado () o más extremos que él. Esto significa que nos preguntamos por la probabilidad que tiene la variable de asumir el valor 7.50 o uno más extremo, -es decir un valor que se aleje más de la media hipotética-, si es verdadera. Tengamos muy presente que:

alejado poco probable si fuera cierta

Por eso, los valores alejados se encuentran en los extremos de la distribución de , bajo el supuesto de verdadera (es decir, centrada en la media hipotética).

Para decidir si la evidencia hallada en la muestra es suficiente para rechazar la hipótesis nula, vamos a establecer a priori un valor máximo para la probabilidad de ocurrencia del valor muestral, o lo que es lo mismo, un valor máximo para el área extrema donde consideraremos que se encuentran los valores “alejados”.

¿cuán alejado? ¿cuán poco probable?

11.2.1 La toma de decisión

La se rechaza si hay poca probabilidad de hallar un valor como el observado o uno más extremo que él. Lo que llamamos poca probabilidad, puede establecerse a priori, por ejemplo en 0.05. Eso indica que consideraremos a los resultados con probabilidad menor a 0.05 como muy improbables de hallar si fuera cierta y, cuando los hallemos, la decisión será rechazarla. Por el contrario, si encontramos valores cuya probabilidad de ocurrencia es superior a 0.05, los trataremos como valores esperables y nos conducirán a no rechazar la .

Como sabemos de la distribución normal, los valores de delimitan un área central de 95%, es decir que dejan fuera un área de 5%. Los valores de superiores a 1.96 ó inferiores a -1.96 tienen una probabilidad de ocurrencia de 0.05, repartida en las dos “colas” de la distribución normal.

Figura 11.2: Áreas extremas que totalizan una probabilidad de 0.05

Los valores de que correspondan a puntajes z que superen a 1.96 ó sean inferiores a -1.96 serán valores con probabilidad menor a 0.05, por lo que serán considerados como poco probables y conducirán a rechazar . Por el contrario, los valores que tengan comprendido entre -1.96 y 1.96 serán probables y llevarán a no rechazar . Estos dos puntos (-1.96 y 1.96) se denominan valores críticos de y se indican con un subíndice: .

En nuestro ejemplo, el valor observado es , de aquí en adelante lo llamaremos (el valor de la media observado en la muestra). El puntaje equivalente a ese se llama observado, se indica como , y vale:

Se trata de la transformación a puntaje del valor observado de la media muestral, que mide a cuántas desviaciones estándar se encuentra de la media hipotética . Se conoce con el nombre de estadístico de prueba.

Este puntaje no está en la zona extrema, porque no va más allá de 1.96; por el contrario, está entre -1.96 y 1.96 que pertenece a la parte de valores centrales de la distribución, los más probables. En consecuencia, la decisión es la de no rechazar y concluir que no hay evidencia para creer que el tiempo se tarda en completar la carrera haya cambiado respecto del valor histórico. Dicho de otra manera, el valor observado de es un resultado esperable si la media poblacional fuera de . Una media muestral de es compatible con una media poblacional de .

Por la forma en que hemos razonado y tomado la decisión, se comprende que a los valores de comprendidos entre -1.96 y 1.96 se los denomine zona de no rechazo de . El otro conjunto de valores de , los mayores a 1.96 junto a los menores a -1.96, constituyen la zona de rechazo de .

Luego de haber considerado a 0.05 como la probabilidad a la que llamamos “pequeña”, quedaron determinados los valores de que indican las zonas de rechazo y de no rechazo.

| La zona de rechazo de es el conjunto de valores extremos de la distribución, donde es poco probable encontrar los valores muestrales si es verdadera. |

| La zona de no rechazo de es el conjunto de valores centrales de la distribución, donde es más probable encontrar los valores muestrales si es verdadera. Es el conjunto de valores muestrales que son compatibles con el valor paramétrico que sostiene la . |

Luego de eso, el procedimiento que seguimos fue: calcular el puntaje que corresponde al valor observado de , y luego ver si éste se encuentra en la zona de rechazo o de no rechazo de .

La probabilidad 0.05 como valor pequeño fue una elección y podría haber sido diferente; ese número tiene una larga tradición histórica, Fisher lo usaba regularmente, aunque aclarando que no era obligatorio y que no hay nada especial para elegirlo69. Se conoce como nivel de significación y se indica con la letra (alfa). Es la probabilidad de hallar un valor como el observado o más extremo que él, si la hipótesis nula fuera cierta, por lo que es una probabilidad condicional que ahora escribimos como:

De esta expresión es importante recordar que mide la probabilidad de hallar a en la región de rechazo (más allá de los puntos críticos) si es verdadera.

El valor que elijamos para indica a qué valores vamos a considerar como poco probables: en este caso se trata de valores tan poco probables como el 5%. Puede usarse un nivel de significación diferente, por ejemplo del 10% y los valores críticos de serán diferentes. En efecto los puntos que dejan un área extrema del 10% son .

En ese caso escribiremos:

| Se llama nivel de significación a la probabilidad de hallar al valor muestral en la zona de rechazo de , si es verdadera. Se indica como , y es elegido por el equipo de investigación. |

Figura 11.3: Áreas extremas que totalizan una probabilidad de 0.10

Por lo que, si el nivel de significación es (), la zona de no rechazo de es el conjunto de valores comprendidos entre -1.64 y 1.64 (centrales), mientras que la zona de rechazo de son los menores a -1.64 y los mayores a 1.64 (los valores extremos cuya probabilidad es el área sombreada en el gráfico). El valor muestral del ejemplo () está también en la zona de no rechazo para este nivel, por lo que tampoco se rechaza la a un nivel de significación de 0.10.

Otro nivel de significación que suele usarse es del 1%. Para él, los valores de son , por lo que la regla de decisión será: “si el valor de correspondiente al valor observado de está entre -2.56 y 2.56 no se debe rechazar la , mientras que si es menor a -2.56 o superior a 2.56 sí debe rechazarse la .

Expresamos la probabilidad condicional como:

Al igual que en los casos anteriores, cuando se expresan en términos de

puntajes z, estos valores son fijos; no dependen de los resultados

muestrales que se encuentren, constituyen una regla de decisión

establecida a priori.

Cuanto más pequeño se elige , tanto más exigente

es la prueba, en el sentido de que solo rechaza la hipótesis de

no-diferencia si se observan valores muy alejados del hipotético. Por el contrario, un se considera un nivel tolerante, porque demanda menos alejamiento para decidir rechazar la .

De manera general, si llamamos al puntaje que corresponde a un área acumulada de de la distribución normal estándar (el percentil ) y al percentil: , la expresión queda:

Y las representaciones gráficas de las áreas de rechazo para los tres niveles de significación mencionados son:

Figura 11.4: Comparación de las zonas de rechazo de con niveles de significación del 10, del 5 y del 1%

Figura 11.5: Comparación de las zonas de rechazo de con niveles de significación del 10, del 5 y del 1%

Figura 11.6: Comparación de las zonas de rechazo de con niveles de significación del 10, del 5 y del 1%

Ejemplo (datos ficticios): para la misma carrera universitaria del ejemplo anterior, el promedio de calificaciones al egreso era, según registros históricos, de 6.50. Nos preguntamos si, luego del cambio en el plan de estudios, esta nota promedio ha cambiado o sigue siendo la misma. El planteo de las hipótesis será ahora:

Por la misma razón que antes, no podemos analizar a la población completa, usaremos los datos obtenidos en una muestra. En ella encontramos, por ejemplo, que el promedio de 100 egresadas y egresados es de 6.65 con desviación estándar de 0.60, es decir: y . A un nivel de significación del 5%, los puntos críticos vuelven a ser . Buscamos el estadístico de prueba transformando el valor observado de a puntaje y encontramos:

El valor observado de corresponde entonces a un que supera al punto crítico (que es ), por lo que está en la zona de rechazo de . La decisión es rechazar y concluir que el promedio al egreso es actualmente diferente del promedio histórico.

En los dos ejemplos vemos que la regla de decisión depende del nivel de significación. Cuando se fija en el 5% entonces se puede expresar como “si el valor de correspondiente al valor observado de está entre -1.96 y 1.96 no se puede rechazar , si es menor a -1.96 o superior a 1.96 se debe rechazar la ”. Cuando el nivel de significación es del 10%, diremos que “si el valor correspondiente al valor observado de está entre -1.64 y 1.64 no se puede rechazar , si es menor a -1.64 o superior a 1.64 se debe rechazar .

Veamos más en detalle el significado de esta probabilidad que hemos fijado en 0.05 y que puede también elegirse en 0.10 ó en 0.01 y que llamamos . Se trata de la probabilidad de hallar el valor observado en la muestra (o uno más extremo a él) si fuera verdadera, por lo que cada vez que hallemos valores muestrales que se encuentran allí, tomaremos la decisión de rechazar . Si la hipótesis nula fuera efectivamente verdadera, la decisión sería incorrecta, pero a eso no lo sabemos, porque nunca conocemos el verdadero valor del parámetro. Aunque sí podemos afirmar que al fijar en el 5%, ésas serán las chances de equivocarnos rechazando una hipótesis nula que era verdadera. En el segundo ejemplo, cuyo resultado fue el de rechazar , es muy importante indicar a qué nivel de significación se toma la decisión, porque ese número (5%) indica la probabilidad de haber tomado la decisión erróneamente. Mide la probabilidad de haber encontrado el promedio muestral de 6.65 por azar. Como esa probabilidad es pequeña, decidimos rechazar .

11.2.2 Los puntos críticos en términos del estimador

Hay una manera diferente de establecer las zonas de aceptación y rechazo, que consiste en fijar los puntos críticos en términos de , en lugar de hacerlo como puntajes . Por lo que en lugar de determinar los dos , hallaremos los dos valores críticos de , a los que llamaremos :

En el ejemplo sobre el tiempo que se tarda en terminar una carrera y a un nivel de significación de 5%, los valores de son:

Al sumar obtenemos 7.55 y al restar 7.05. Estos son los puntos críticos expresados en términos de la variable original. La regla de decisión es ahora “si se encuentra un valor de comprendido entre 7.05 y 7.55 no se puede rechazar la . Si el valor observado de es inferior a 7.05 ó superior a 7.55 se debe rechazar .

Para expresarlo como probabilidad condicionada:

Que afirma que la probabilidad de hallar a por debajo de 7.05 o por encima de 7.55 si la media de la población es 7.30, vale 0.05.

Al hacer la prueba, vemos que , que no va más allá de los puntos críticos, por lo que pertenece a la zona de no rechazo de . Concluimos que no se rechaza y que no ha cambiado el tiempo que se tarda en terminar la carrera.

La regla de decisión es la misma que antes, solo que ahora está expresada en el lenguaje de y no de y la conclusión también es la misma.

Volviendo ahora sobre el caso de los promedios al egreso, para hallar los valores críticos de la media muestral hacemos:

Y resultan: 6.38 y 6.62. El promedio observado fue de 6.65, que supera al punto crítico superior y se encuentra en la zona de rechazo. Concluimos que se rechaza la y que, con el nuevo plan, la calificación promedio al egreso difiere de la histórica. Nuevamente, es la misma conclusión que si se trabaja sobre .

Comparemos los dos procedimientos:

A. Usando valores críticos de

Habiendo establecido el nivel de significación, determinar los valores que dejan esa probabilidad en los extremos. Éstos son los .

Para hallar el estadístico de prueba, transformar el valor observado de en puntaje haciendo:

- Observar la posición de este valor transformado en la distribución de probabilidades z

Para un nivel de significación de 0.05 (ó 5%), en el ejemplo, el gráfico es el 11.7:

Figura 11.7: Ubicación de la zona de rechazo de a un nivel de significación de 0.05, sobre puntajes estándar (), y del valor observado

B. Usando los valores críticos de

Habiendo establecido el nivel de significación, determinar los valores que dejan esa probabilidad en los extremos. Éstos son los .

Usar los para determinar los correspondientes haciendo:

- Ver la posición de en la distribución de probabilidades de .

Para el nivel de significación de 0.05 y el mismo ejemplo, resulta el gráfico 11.8.

Figura 11.8: Ubicación de la zona de rechazo de a un nivel de significación de 0.05, sobre valores de la variable , y del valor observado

La diferencia entre las dos formas de establecer los puntos críticos es que con la primera se determinan los valores de a partir del nivel de significación y luego se transforma a puntaje el valor muestral observado de .

En el segundo modo, los se transforman (al revés) en puntos críticos de y luego se compara el directamente, sin transformarlo.

Los gráficos 11.7 y 11.8 expresan lo mismo, el primero en el lenguaje estandarizado de , el segundo en el de . Los procedimientos son equivalentes y puede vérselos aplicados de manera indiferenciada. Las campanas tienen la escala del eje horizontal ajustada para que mantengan la misma forma, y así quede clara la equivalencia de los procedimientos, pero no debe olvidarse que la variabilidad es diferente entre las dos distribuciones. La primera está estandarizada a uno y la segunda depende de la varianza poblacional y del tamaño de la muestra. La primera corresponde a una normal estándar, con , mientras que, en este ejemplo, la segunda es la distribución normal de las , con .

11.2.3 Pruebas unilaterales

A menudo la hipótesis alternativa no expresa solo que la media difiera del valor hipotético, sino que indica en qué dirección se espera que difiera. Por ejemplo, puede esperarse, en el ejemplo anterior, que la carrera es termine con promedio superior a 6.50, con lo que ahora la dirá que . Se trata en este caso de una prueba unilateral y solo rechazaremos la si encontramos valores sustancialmente mayores que 6.50. Para el mismo nivel de significación del 5%, el valor que nos interesa es el que delimita un área superior de 0.05.

Notemos la diferencia con las pruebas que tratamos antes: al nivel de 5% buscábamos dos que dejaban en total 0.05 de área extrema (por encima y por debajo) o lo que es lo mismo, los dos que dejan el 95% del área central. Ahora, como la prueba es unilateral y solo nos interesan valores que se excedan, solo buscamos un crítico, el que deja al 5% por encima. Ese valor de es 1.64.70

Figura 11.9: Ubicación de la zona de rechazo de Ho para una prueba unilateral derecha a un nivel de significación del 5%

Por oposición a las anteriores, las pruebas unilaterales se llaman pruebas de una cola. Como vemos en el gráfico, el conjunto de valores que conducen a rechazar se encuentran solo a la derecha.

Ejemplo (datos ficticios): en la situación en que nuestro interés esté en analizar si el promedio al egreso es superior al valor histórico (y no solo diferente a él), las hipótesis de la prueba se expresan:

Haremos la prueba sobre los valores de , a un nivel de significación del 5% entonces:

Al sumar obtenemos 6.60, que es el único punto crítico que nos interesa por tratarse de una prueba unilateral y hemos sumado porque la prueba es derecha. Con lo que resulta la siguiente región de rechazo de :

Figura 11.10: Región de rechazo unilateral derecha de a un nivel de significación del 5%, con una muestra de 100 casos y desviación estándar 0.60, y ubicación del valor observado del estimador

El valor observado de había sido 6.65 que es mayor que el punto crítico, con lo que rechazamos la y concluimos que el promedio al egreso es significativamente mayor al histórico.

Si hubiésemos planteado la regla de decisión sobre los valores de , a un nivel de significación del 5%, hay que calcular el puntaje correspondiente al valor observado de la media muestral:

Dado que este resultado supera al punto crítico , concluimos nuevamente que el promedio al egreso es significativamente mayor al histórico.

En los párrafos anteriores hemos introducido una expresión nueva, que tiene un sentido preciso. Cuando decimos “significativamente mayor” no nos referimos al uso que suele darse en el lenguaje cotidiano, que es sinónimo de importante, de gran magnitud, grande, etc. Diremos que un valor es significativamente mayor o menor si se ha rechazado una prueba unilateral, o bien que es significativamente diferente o que la diferencia es significativa, si la que fue rechazada pertenece a una prueba bilateral. Además debe indicarse el nivel de significación de la prueba, por lo que diremos: según los datos observados y a un nivel del 5%, la calificación promedio al egreso de la carrera es significativamente superior a la histórica.

| Un resultado es significativo cuando conduce a rechazar una a un determinado nivel de significación. |

Un resultado puede ser significativo a un nivel y no serlo a otro. Por ejemplo, si en una prueba bilateral y luego de transformar el valor observado a puntaje , se obtiene , este resultado conducirá a que se rechace al 5% (porque es mayor que ) pero que no se rechace al 1% (porque no es mayor que ). En ese caso diremos que se obtienen resultados significativos al 5% pero no al 1%. Luego veremos que esta clasificación puede hacerse más precisa.

11.2.4 Otros ejemplos de prueba de hipótesis sobre la media

La investigación con sujetos animales en Psicología se basa en que distintas especies comparten mecanismos básicos, y los animales no humanos presentan un nivel de complejidad menor, lo que facilita la comprensión de fenómenos complejos en personas. De hecho, los modelos animales han permitido avanzar en el conocimiento de mecanismos neurofisiológicos, cognitivos y comportamentales de seres humanos, siendo clave en el ámbito de la psicopatología y terapia psicológica.

En este contexto, alumnas de Psicología interesadas en la vulnerabilidad adolescente hacia el uso y abuso de drogas, recurrieron a un modelo animal para estudiar los efectos del alcohol Dziula and Reyna (2005). Uno de los posibles factores que determinan las primeras aproximaciones a las drogas es la búsqueda de nuevas sensaciones, que se manifiesta en niveles elevados tanto en adolescentes humanos como no humanos, particularmente en roedores. En modelos animales, una manera de indagar el comportamiento de búsqueda de novedad es a través del uso de un objeto novedoso. Debido al escaso conocimiento sobre el comportamiento de los roedores ante tales objetos, las alumnas desarrollaron un estudio piloto. Concretamente, expusieron a 32 ratas Wistar71 adolescentes (28 a 42 días de edad) a un objeto novedoso durante 3 minutos en distintos intervalos de tiempo.

A continuación, se retoman datos parciales del estudio piloto a los fines de exponer la modalidad de trabajo cuando se realiza una prueba de hipótesis sobre un valor determinado de la media. Primero ilustramos el caso de una prueba bilateral y luego unilateral.

Ejemplo (datos modificados72): en algunos estudios se ha observado que el tiempo que tardan los roedores (en general) en contactar un objeto novedoso (llamado tiempo de latencia, o simplemente latencia) es de 150 seg. En función de ello, se indaga si la latencia de contacto con el objeto en ratas Wistar adolescentes es la misma o no en relación a la reportada previamente en otros trabajos con roedores. Las hipótesis formuladas son:

En la muestra utilizada, la latencia media de contacto con el objeto es de 138.42 seg. y la desviación estándar 42.98. Se establece un nivel de significación del 5%, por lo que los puntos críticos en puntajes z son

Luego, se transforma el valor de observado en puntaje a través de la siguiente fórmula:

Vemos que al valor de le corresponde un valor que se encuentra entre los puntos críticos , es decir que se halla en la zona de no rechazo de la , por lo que concluimos que no hay evidencia que indique que la latencia media de contacto con un objeto novedoso en ratas Wistar es distinta a la latencia que manifiestan los roedores en general.

Se obtiene la misma conclusión si se utilizan los valores críticos de . Revisemos el procedimiento: luego de haber establecido el nivel de significación al 5%, se obtienen los puntos críticos en puntajes originales () a partir de los puntos críticos en puntajes (los ), a través de la siguiente fórmula73:

Entonces, los que delimitan las zonas de rechazo y no rechazo son 135.02 y 164.89, y el valor observado de se encuentra comprendido entre ellos, por lo que no se rechaza la .

Ejemplo (datos reales74): la literatura sobre comportamiento exploratorio en roedores (en general) indica que cuando los organismos son expuestos durante 180 seg a un objeto novedoso permanecen en contacto con el mismo (duración) 14 seg en promedio. Debido a las características del período adolescente, en este trabajo se formula una hipótesis que indica que las ratas adolescentes estarán más tiempo en contacto con el objeto. Las hipótesis formuladas son:

En los animales que comprenden la muestra bajo análisis, se observa que la duración de contacto con el objeto es de 17.43 seg y la desviación estándar 4.25. El nivel de significación se establece en el 5% y, dado que la prueba es unilateral derecha, el punto crítico en puntaje es 1.64.

Luego, transformamos el valor de observado en puntaje :

Al valor de observado le corresponde un valor , que resulta superior al , por lo que se rechaza la , es decir que las ratas adolescentes muestran una duración mayor de contacto con un objeto novedoso que lo señalado por la literatura para roedores en general.

Obtenemos la misma conclusión si usamos los valores críticos de . Una vez establecido el nivel de significación al 5%, se obtienen los puntos críticos en puntajes originales () a partir de los puntos críticos en puntajes ()75:

El valor observado de resulta mayor a , por lo que se rechaza la , y concluimos que la duración promedio de contacto con un objeto novedoso en ratas adolescentes es significativamente mayor a 14.

Ejemplo (datos reales): luego de haber evaluado la latencia de contacto con un objeto novedoso de los animales en repetidas ocasiones, se observa un valor promedio de 112.48 seg. Ahora, el equipo de investigación se interesa en indagar cuál será la latencia de contacto si las ratas son nuevamente expuestas al objeto novedoso, suponiendo que será menor debido a la disminución del carácter novedoso que hacía que los animales tardaran en contactar el objeto en las exposiciones iniciales. Las hipótesis formuladas son:

En la nueva exposición, la latencia promedio de contacto con el objeto es de 71.36 y la desviación estándar es de 45.77. El nivel de significación se establece en el 5% y, dado que la prueba es unilateral izquierda, el punto crítico en puntaje es .

Luego, transformamos el valor de observado en puntaje con el estadístico de prueba:

Vemos entonces que al valor de observado le corresponde un valor , que resulta inferior al , por lo que se rechaza la , es decir que se concluye que, a un nivel de significación del 5%, la latencia de contacto con el objeto novedoso en una nueva exposición es significativamente menor a 112.48 seg.

A la misma conclusión se arriba si se realizan los cálculos con los valores críticos de , que se obtienen a partir de los puntos críticos en puntajes /, a través de la siguiente fórmula76:

El valor observado de resulta menor a , por lo que se rechaza la , la latencia promedio de contacto con el objeto novedoso en la nueva exposición es, al 5% de significación, significativamente menor a 112.48 seg.

Debemos recordar que el carácter unilateral o bilateral de la prueba no depende de la sino de la . En efecto, la siempre indica un valor determinado para el parámetro (hasta aquí la media), mientras que la puede indicar un valor diferente si la prueba es bilateral, o bien señalar la dirección de la diferencia hacia los mayores o menores y en esos casos, la prueba es unilateral. La decisión de hacer una prueba unilateral o bilateral depende de cada investigación concreta, de la pregunta que el investigador formula.

| Bilateral | Unilateral derecha | Unilateral izquierda | |

|---|---|---|---|

11.3 Prueba sobre la proporción

De modo equivalente a los intervalos de confianza, comenzaremos con la prueba de hipótesis sobre una proporción usando la distribución binomial, para luego usar la aproximación normal, si los supuestos se cumplen. El procedimiento conlleva los mismos pasos que cuando se trata de la media: se plantean, en primer lugar, las hipótesis nula y alternativa. La hipótesis nula afirma un valor para la proporción poblacional, mientras que la hipótesis alternativa puede, o bien solo indicar que el valor es diferente (prueba bilateral), o bien precisar si la diferencia se espera hacia valores mayores o menores que los indicados por la hipótesis nula (prueba unilateral). Una vez fijado el nivel de significación () y la lateralidad de la prueba, deben determinarse los valores de que dejan esa probabilidad por encima (en el caso de una prueba unilateral derecha), por debajo (unilateral izquierda), o bien repartida en ambas colas (si es una prueba bilateral). La determinación de esos puntos se realiza con la distribución binomial, por lo que es necesario transformar la variable proporción de éxitos () al número de éxitos (). Esta transformación vale para la proporción hipotética () y para la observada (): es decir Del mismo modo que: equivale a

Ejemplo (datos ficticios): un partido político tenía, haces tres meses una intención de voto equivalente al 30% del padrón. De acuerdo con algunas acciones de campaña, se cree que esta proporción pudo haber aumentado, por lo que el planteo de las hipótesis es:

Hipótesis que se pondrá a prueba sobre una muestra de 50 casos. Al igual que sucedió con la media, estos son valores que planteamos de manera hipotética acerca del parámetro, en este caso la proporción poblacional (). La indica que la proporción de votos sigue siendo la misma. Se trata de una prueba unilateral derecha, porque el interés está en encontrar un eventual aumento en la proporción de votantes que tiene el partido, por eso la indica una proporción mayor.

Se fija un nivel de significación de 5% y, para determinar los puntos críticos bajo un modelo binomial, se transforma el valor hipotético de al correspondiente a X en la muestra dada:

Con lo que el punto crítico es el valor de que deja por encima (porque es una prueba unilateral derecha) al 5% de los valores posibles. Buscamos el percentil 95 de la distribución binomial correspondiente a los parámetros: , y

La probabilidad es la de la cola derecha de la distribución, por ser una prueba unilateral derecha, y corresponde a una probabilidad acumulada de 0.95, de modo que el percentil es 95, que equivale a es:

## [1] 20El número de éxitos es 20. Por lo que el valor de que es superado por el 5% de los valores muestrales posibles es 20. La representación gráfica es la siguiente:

Repasemos la interpretación de estas operaciones: si la proporción de votos que el candidato tiene en la población total fuera del 30% (esa es la hipótesis nula), entonces se esperaría que en una muestra de 50 casos, haya 15 que lo voten (15 es el 30% de 50, es la media de la distribución binomial; su esperanza). Como la muestra es aleatoria, la cantidad de votos que se obtienen en ella es aleatoria, puede ir desde cero hasta cincuenta, con diferentes probabilidades, que muestra el gráfico anterior. El criterio del 5%, establece al valor 20 votos como punto crítico. Eso quiere decir que, si la proporción de votos que el candidato tiene en toda la población fuera del 30%, la probabilidad de encontrar más de 20 votos en una muestra de 50 es menor al 5%. La regla de decisión será entonces: rechazar la hipótesis nula si en la muestra se encuentran más de 20 votos.

Si en la encuesta realizada sobre la muestra de 50 casos se encuentran 16 personas que dicen que lo votarán (con lo que77 ), la decisión será la de no rechazar y considerar que no hay evidencia para creer que la proporción de votos que el candidato tiene, haya aumentado de su 30% anterior.

El punto crítico situado en 20 éxitos equivale a . La comparación de los 16 éxitos muestrales con los 20 del punto crítico es la misma que la del 32% muestral frente al 40% crítico.

Si se tratara de una muestra de mayor tamaño y tanto como fueran mayores a 5, podríamos usar la aproximación normal de la distribución binomial. Para ello, establecemos un nivel de significación de 5%, y el valor crítico de (en prueba unilateral) es . Ahora en términos de , la zona de rechazo queda así:

Una vez fijado el nivel de significación () y la lateralidad de la prueba (derecha), quedan determinados el o los puntos críticos en términos de .

La principal diferencia a tener en cuenta para la transformación a puntaje de la proporción es el cálculo de su error estándar que, en la aproximación normal de la distribución en el muestreo de las es:

En la construcción de intervalos de confianza es necesario aproximar a través de , porque se ignora el valor de la proporción poblacional. Pero en la prueba de hipótesis, la situación es diferente, porque se cuenta con una (poblacional) hipotética, y es esa la que se utiliza para el cálculo de . Por lo tanto, la transformación del valor observado en la muestra a puntajes se hará según:

Que es el estadístico de prueba para la prueba de proporciones que debe usarse cuando sea válida la aproximación normal para la distribución binomial. De acuerdo a que la posición de este sea en la zona de rechazo o no rechazo de , se toma la decisión.

Nuevamente sobre el ejemplo con las mismas hipótesis, nula y alternativa

Sea ahora que se trató de una muestra de 200 personas habilitadas para votar, en la que se halla que 64 dicen que van a votar a ese candidato (de este modo la proporción muestral sigue siendo de 32%). En la muestra entonces:

Nos preguntamos si este valor puede considerarse como un verdadero aumento respecto del 30% anterior o si solo se explica por razones de azar. Repitiendo la operación que realizamos para la media, transformamos este valor observado de la proporción muestral a puntaje y hallamos el estadístico de prueba:

Este puntaje de no supera al punto crítico () por lo que se sitúa en la zona de no rechazo de . Concluimos que la proporción no ha aumentado respecto del valor anterior.

Para repetir la prueba sobre valores del estimador , vamos a transformar el punto crítico de acuerdo a la expresión general:

de la que usaremos ambos signos cuando se trate de una prueba bilateral o solo la suma si es unilateral derecha o solo la resta si es unilateral izquierda. Para nuestro problema, corresponde sumar, por lo que resulta:

Representamos gráficamente la zona de rechazo como la cola derecha de la distribución de las :

El valor hallado en la muestra () es menor que el punto crítico, por lo que no está en la zona de rechazo, en consecuencia, no rechazamos la y concluimos que no hay evidencia para creer que el candidato haya aumentado su proporción de votos. Como había sucedido antes, la conclusión es la misma si trabajamos sobre los puntajes estandarizados o sobre valores del estimador. Sin embargo, el punto crítico expresado en términos de es diferente, cuando se usó la distribución binomial su valor fue 40% y ahora es 35%.

En los ejemplos siguientes trabajaremos con muestras grandes por lo que las pruebas se realizan usando la aproximación normal.

Ejemplo (datos reales): en el estudio Latinobarómetro78 se menciona la importancia de comprender la percepción de la gente sobre el cambio generacional: cómo creen que vivían sus padres y madres, y cómo creen que vivirán sus hijos e hijas. En el año 2004, el 58.2% de las personas encuestadas en Argentina consideraba que los hijos e hijas vivirían mejor que ellos. En el año 2005, se indaga nuevamente la expectativa futura. Dado que se habían observado fluctuaciones en años previos, cabe preguntar si esa expectativa positiva habrá cambiado o no respecto del año anterior. Las hipótesis que se formulan son:

En el estudio del año 2005, observaron que 676 participantes de 1200 que componían la muestra consideraban que sus hijos e hijas vivirían mejor que la generación anterior, con lo que, la proporción en la muestra es:

El nivel de significación se establece al 5%, por lo que los puntos críticos en puntajes son (prueba bilateral).

Para responder a la hipótesis planteada, se transforma el valor de proporción observado a puntaje haciendo:

El valor se encuentra entre los puntos críticos , es decir que se halla en la zona de no rechazo de la , por lo cual se concluye que no hay evidencia que indique que la proporción de expectativas positivas haya cambiado; la proporción no es significativamente distinta de 0.582.

Se alcanza la misma conclusión si se realizan los cálculos en función de los valores del estimador. Establecido el nivel de significación en el 5%, se obtienen los puntos críticos en puntajes originales () a partir de los puntos críticos en puntajes ():

De esta manera se obtienen los que delimitan las zonas de rechazo y no rechazo: 0.55 y 0.61. El valor se encuentra comprendido entre ellos, por lo que no se rechaza la .

Ejemplo (datos reales): otro de los aspectos indagados en el estudio Latinobarómetro se refiere a la opinión sobre progreso en la reducción de la corrupción en las instituciones del Estado. En el año 2004, en Argentina, el 3.33% de quienes respondieron consideraba que se había progresado mucho en ese aspecto. En el estudio del 2005, se espera que los resultados sean más favorables debido a la aplicación de una serie de medidas tendientes a controlar la corrupción institucional. Así, las hipótesis que se formulan son:

De las 1200 respuestas recogidas en el año 2005, 51 indican que se ha progresado mucho en reducir la corrupción institucional, es decir que la proporción en la muestra es

El nivel de significación se establece en el 5%, dado que la prueba es unilateral derecha el único punto crítico en puntaje es .

Luego, se transforma el valor de proporción observado en puntaje , usando el estadístico de prueba:

El valor resulta superior al , por lo que se rechaza la . Por eso concluimos que la proporción de personas que declara que se ha progresado en la reducción de la corrupción institucional se incrementó de manera significativa.

Se obtiene la misma conclusión a partir de los valores del estimador. Establecido el nivel de significación en el 5%, se obtiene el punto crítico en puntaje original () a partir del punto crítico en puntaje ():

El valor observado de resulta mayor a , por lo que se rechaza la , y se concluye que la proporción de quienes creen que se ha progresado en la reducción de la corrupción institucional se ha incrementado de manera significativa de 2004 a 2005.

Ejemplo (datos reales): otro tema que aborda Latinobarómetro es el interés por la política. En el estudio del año 2004, el 11% de las personas encuestadas en Argentina manifestó estar muy interesado en la política. Si bien no ha habido notables cambios en la última década con respecto al interés de la ciudadanía en la política, una serie de indicadores llevaron al equipo de investigación a considerar que el interés en esta cuestión podría haber disminuido. Las hipótesis planteadas son:

De la muestra de Argentina de 1200 casos correspondiente el año 2005, 111 manifiestan un elevado interés en la política, la proporción en la muestra es:

El nivel de significación se establece en el 5%, dado que la prueba es unilateral izquierda el punto crítico en puntaje es . Con el estadístico de prueba se transforma el valor de proporción observado en puntaje :

El valor resulta inferior al , por lo que se rechaza la . Concluimos que la proporción de personas que manifiestan elevado interés en la política ha disminuido de manera significativa de un año al siguiente.

Como antes, puede alcanzarse la misma conclusión realizando los cálculos con el valor crítico del estimador:

El valor observado de resulta menor a , por lo que se rechaza la . Se concluye entonces que, en Argentina, la proporción de personas con alto interés en la política en el año 2005 es significativamente menor a 0.11.

11.4 Tipos de error en las pruebas de hipótesis

Dado que la decisión de aceptar o rechazar la se toma de manera probabilística, siempre existe la posibilidad de tomar una decisión incorrecta. Esto sucede porque las muestras son tomadas al azar y puede suceder que la que usamos para tomar la decisión sea una muestra extrema. Aunque es un resultado poco probable, no es imposible.

Como hemos visto, el nivel de significación mide la probabilidad de hallar un determinado resultado muestral si la fuera cierta, es una probabilidad pequeña, que habitualmente fijamos en 0.05 ó 0.01. Si la es cierta y la muestra sobre la que basamos la decisión es extrema, es decir, tiene un valor ubicado en alguna de las colas de la distribución, la decisión será la de rechazar y esa decisión será errónea. La decisión de rechazar puede deberse o bien a que sea efectivamente falsa, o bien a que sea verdadera y se haya obtenido una de esas muestras muy poco probables. Por esta razón el nivel de significación mide la probabilidad de errar en la decisión de esta manera: rechazando una que es verdadera. Al igual que en los intervalos de confianza, éste no es un error de cálculo ni una equivocación, sino una imprecisión inherente a todos los procesos de estimación. Éste error se conoce como Error de Tipo I (ETI).

| El Error de Tipo I es tomar una decisión errónea que consiste en rechazar la cuando esta es verdadera. Su probabilidad está fijada de antemano y es , el nivel de significación de la prueba. |

En consecuencia, establecer es afirmar que se está dispuesto a correr ese riesgo de cometer el ETI. En un experimento que consiste en decidir si una droga produce efectos sobre un determinada patología, la dirá que no hay efecto, por lo que cometer el ETI será creer que hay efecto (rechazar ) cuando en realidad no lo haya ( verdadera). Como no sabemos si es verdadera o falsa, cada vez que rechacemos debemos recordar que hay una probabilidad de haber tomado una decisión incorrecta. Esta incertidumbre está siempre presente en evaluación humana en los campos psicológico y educativo, así como en la evaluación de efectos e impactos de programas de intervención social, o en la comparación de grupos para conocer diferencias entre varones y mujeres, medir los efectos del nivel de educación, etc. En general, está presente en la toma de decisión en contextos de incertidumbre, que son aquellos en que no se conoce a todos los elementos de una población, sino a una muestra de ellos.

Ejemplo ilustrativo: las preguntas de un examen oral son una muestra de

lo que quien está rindiendo sabe y, si se usa un bolillero, la elección del tema que debe desarrollarse es aleatoria. Supongamos que alguien va a un examen y ha estudiado muy poco, pero la unidad que le toca desarrollar es la única que sí estudió.

En ese caso responderá correctamente y la decisión del o la docente será darle por aprobado el examen. Si supiéramos que ignora todos

los demás temas de la materia, la decisión correcta sería que no

apruebe. La formalización de este problema es la siguiente: la

hipótesis nula es la conservadora, esto es, que quien rinde no sabe; será necesario sumar evidencia para que se tome la decisión de rechazar esa hipótesis y dar el examen por aprobado. La muestra de información que tiene el o la docente a su disposición (las unidades que salieron por azar) es correctamente desarrollada, lo que conduce a la

decisión de rechazar la y dar el examen por aprobado. Para quien tiene toda la información (que quien rindió solo sabía esa unidad del programa), se ha cometido un Error de Tipo I, pero el o la docente nunca lo sabrá. Si el programa tenía 20 unidades, la probabilidad de extraer la única bolilla que sabe es , si la saca, se trata de una de esas “muestras extremas” que llevan a tomar la decisión incorrecta a la que llamamos Error de Tipo I.

En investigación nunca tenemos “toda la información”, trabajamos con muestras, por lo que nunca sabemos si, cuando rechazamos y concluimos que algo cambió o que hay un efecto, estamos cometiendo este error o no. Esta es la razón por la que se elige con valores pequeños, pero no se puede reducir indefinidamente el valor de , porque también existe el riesgo de no rechazar siendo falsa.

Éste es otro tipo de error, que se llama Error de Tipo II (ETII) que sucede cuando no se rechaza una , siendo ésta falsa. En el experimento anterior, cometer este error consiste en creer que la droga no es efectiva (no rechazar ) cuando en realidad sí tiene efectos ( es falsa). En el ejemplo del examen, se trata de aplazar a alguien que rindió (aceptar ) cuándo sí sabía, porque le tocó -a la inversa que en el caso anterior- una de las únicas bolillas que no había estudiado.

| Se llama Error de Tipo II a la decisión equivocada de no rechazar una hipótesis nula cuando ésta es falsa. |

Según la prueba de que se trate, el costo de cometer cada tipo de error es diferente. Si se trata de evaluar el efecto de una intervención terapéutica, la dirá que no produce efectos. Entonces, cometer un ETI equivaldrá a recomendar la intervención y que no produzca efecto. Mientras que el ETII consistirá en desestimar una intervención que sí tenía efectos. Si se trata de una intervención muy riesgosa, el ETI es muy grave, porque implicará poner en peligro al paciente, por nada. Por su parte, el ETII conlleva la pérdida del beneficio que la intervención habría dado. La decisión sobre qué error es más grave debe tomarse en cada caso y no pertenece al terreno de la estadística.

Esto se vincula a los errores a que están expuestas las pruebas diagnósticas.

Cuando la prueba da un resultado positivo al ser aplicada a una persona sana, se llama falso positivo. De modo más general, esa expresión indica que el error consiste en creer que “sucedió algo” cuando no fue así y corresponde, en las pruebas de hipótesis, al ETI.

De modo equivalente, el resultado negativo de una prueba diagnóstica aplicada a una persona que sí está enferma se llama falso negativo. Se trata del error opuesto, porque cuando se comete se cree que “no sucedió nada” cuando en realidad sí sucedió. Es el ETII.

Si insistimos sobre estos errores es para llamar la atención sobre dos aspectos fundamentales de las pruebas de hipótesis:

Las conclusiones son probabilísticas, no son verdaderas ni falsas.

Toda conclusión proveniente de estos procedimientos está sujeta a error.

Y estos no son problemas del procedimiento de prueba de hipótesis, sino que es reflejo de las posibilidades humanas de construir conocimiento: no hay certezas, solo hay aproximaciones.

11.5 ETII: , y

A diferencia del ETI, la probabilidad de cometer un ETII no es fijada de antemano, al contrario, el riesgo de creer que es verdadera cuando no lo es, depende de cuál sea la verdadera. Intuitivamente: no es igualmente probable creer que no hay diferencia entre dos valores cuando en realidad éstos son muy cercanos, que cuando difieren mucho, es más fácil confundir cosas que están cerca (creyendo que son iguales) que cuando están lejos.

Llamaremos a la probabilidad de cometer el ETII y veremos cómo calcularla según las diferentes posibilidades del verdadero valor del parámetro sobre el cual se realiza la prueba.

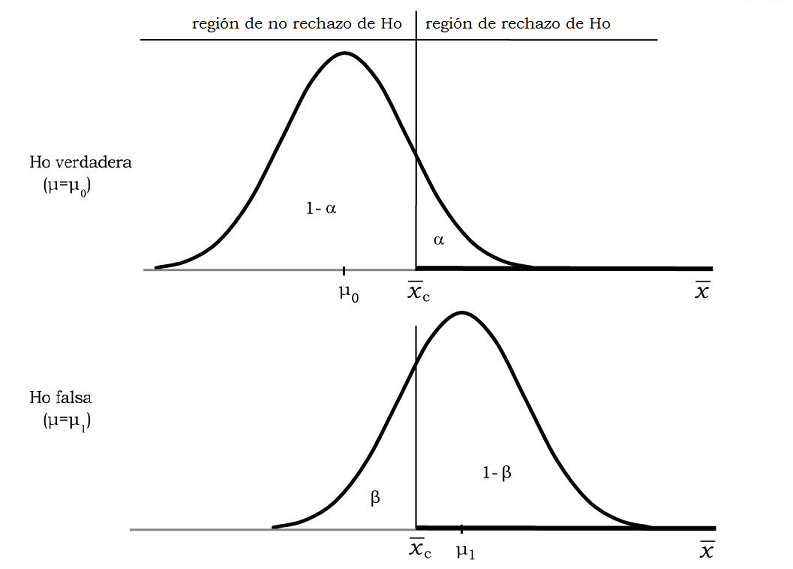

El gráfico 11.11 corresponde a una prueba de hipótesis unilateral derecha sobre la media poblacional79, con la forma:

Donde es un valor determinado e hipotético para la media de la población. En el gráfico se ha ubicado ése valor hipotético y la zona de rechazo de , estableciendo el nivel de significación () en 0.05. Además, hemos dibujado otra curva, centrada en otra media poblacional que podría ser verdadera80. Así, la curva superior representa la distribución de probabilidad de si fuera verdadera (). La curva inferior muestra la distribución de probabilidades de si fuera falsa () y la verdadera media poblacional fuera (que es una de las posibles entre las mayores que ).

Figura 11.11: Comparación de la probabilidad de hallar a en zona de rechazo o no rechazo, según sea verdadera o falsa

La parte superior del gráfico muestra que, si es verdadera, tiene una probabilidad de estar en la zona de rechazo, por lo que, si es verdadera y está en esa zona, tomaremos la decisión errada de rechazarla. El complemento del nivel de significación (), es la probabilidad de tomar la decisión correcta de no rechazar cuando ésta es verdadera. Es la probabilidad de hallar a en la zona de no rechazo de .

En la parte inferior del gráfico vemos que, si es falsa, tiene probabilidad de estar en la zona de rechazo, lo que llevará a tomar la decisión correcta de rechazar una falsa. Bajo el mismo supuesto de falsa, es el área correspondiente a la zona de no rechazo de , por lo que mide la probabilidad de errar aceptando una falsa.

Debido a que no podemos tener certeza acerca de la verdad o falsedad de , es que se nos plantean dos posibles escenarios: que sea verdadera o que sea falsa. En base a los datos con que contamos en la muestra podemos tomar dos decisiones: rechazar o no rechazarla, con lo que la decisión que tomemos puede ser correcta o incorrecta.

Esquema 1: Posibles combinaciones de estados de realidad y decisión que se toma. (Entre paréntesis, la probabilidad de cada evento):

| No rechazar | Rechazar | |

|---|---|---|

| Verdadera | Decisión correcta () | Error de tipo I () |

| Falsa | Error de tipo II () | Decisión correcta (1-) |

La última celda del esquema corresponde a la decisión correcta de rechazar una que es falsa, y se la denomina potencia de la prueba. Es un indicador de la capacidad de la prueba para detectar hipótesis nulas que son falsas y rechazarlas.

| Se llama potencia de una prueba a la probabilidad de rechazar una cuando ésta es falsa. |

Es una importante medida de la calidad de la prueba, luego volveremos sobre su cálculo, y en el último capítulo ofrecemos más detalles.

Así entonces, es elegido en el marco de la investigación, según criterios del equipo y mide el riesgo que está dispuesto a correr de rechazar una que es verdadera. Por el contrario, depende de varios elementos:

En primer lugar, depende de : si se reduce el nivel de significación, aumenta el riesgo de cometer ETII.

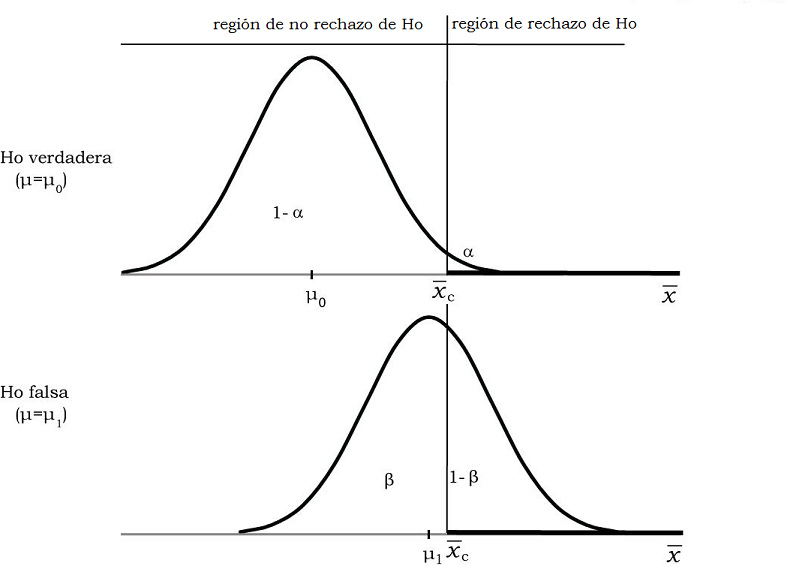

Si se cambia el gráfico 11.11, reduciendo el nivel de significación, ahora la posición relativa de las áreas de rechazo y no rechazo queda:

Figura 11.12: Comparación de la probabilidad de hallar a en zona de rechazo o no rechazo, según sea verdadera o falsa

Como vemos, la reducción del nivel de significación del 5% al 1% hace que el punto crítico se desplace hacia la derecha y, en consecuencia, que aumente el área bajo la otra curva, que corresponde a falsa. Este cambio consiste en hacer a la prueba más exigente, al reducir las chances de rechazar por error, del 5 al 1%. Su consecuencia es la de aumentar las chances de aceptar por error, aumentando el valor de .

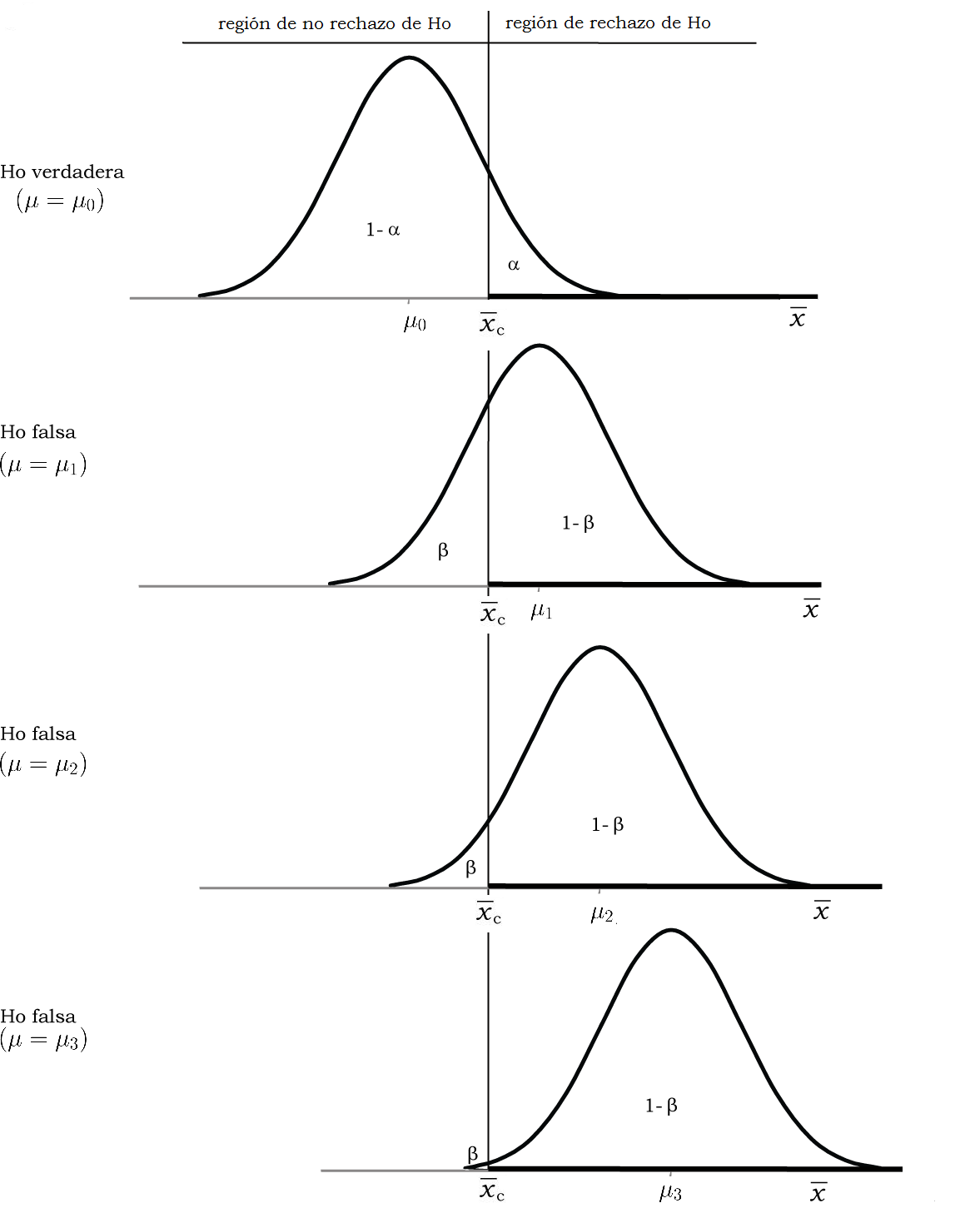

El ETII depende también de cuál sea la verdadera media poblacional. En los gráficos 11.11 y 11.12 planteamos como “otra posibilidad” que la verdadera media fuera , que es una de las formas en que puede ser falsa. Siendo falsa, puede tener distintos valores y ellos incidirán en la probabilidad de cometer ETII. En el gráfico siguiente, además de agregamos otras dos medias poblacionales posibles y .

Figura 11.13: Comparación de la probabilidad de hallar a en zona de rechazo o no rechazo, según sea verdadera o falsa, de tres modos diferentes

El gráfico muestra que si la verdadera media poblacional difiere mucho de la hipotética (como es el caso de ), es menor la probabilidad de cometer ETII: va decreciendo a medida que se consideran medias más alejadas de la que sostiene la . Ésta es una manera de formalizar la idea intuitiva que mencionamos más arriba: es más fácil aceptar un valor equivocado de si el verdadero se le parece, que si es muy diferente. Más concreto aún: es más fácil aceptar por error un billete falso si se le parece mucho al verdadero que si es muy distinto, y cuanto más difiera, menor será la probabilidad de aceptarlo por error.

El gráfico 11.13 también muestra que, de manera complementaria, (la potencia de la prueba), va creciendo a medida que se consideran medias alternativas más alejadas de la hipotética.

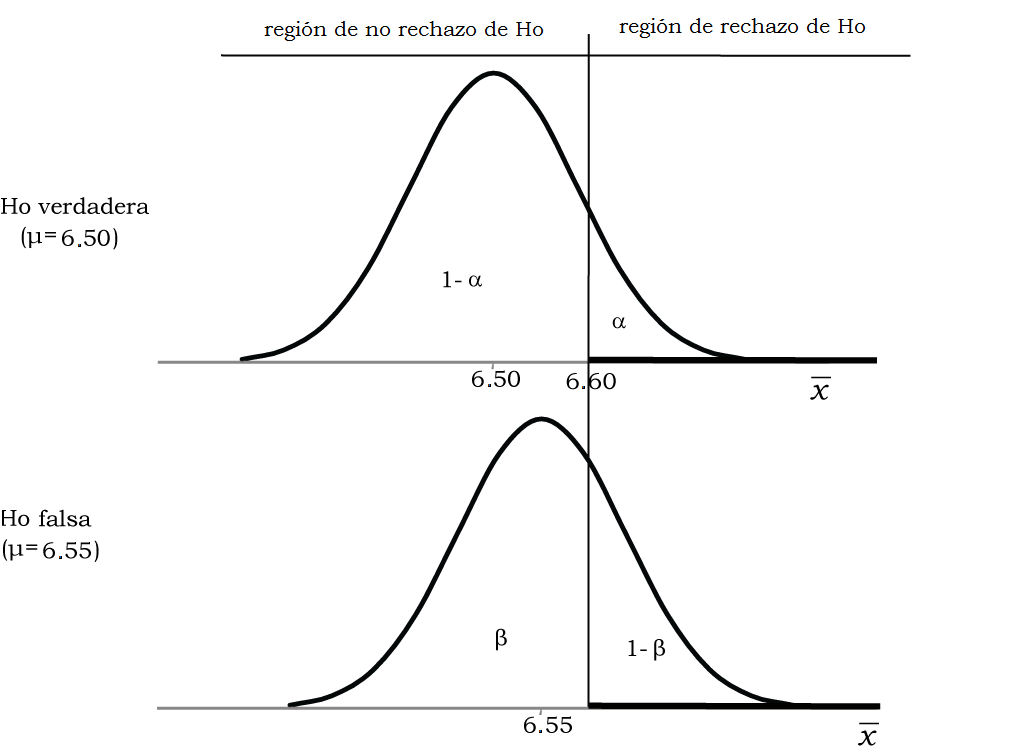

Volvamos al ejemplo (ficticio) sobre el promedio al egreso de una carrera universitaria en la prueba unilateral derecha, cuyas hipótesis son:

Preguntamos: si la verdadera media de nota al egreso fuera de 6.55, ¿cuál habría sido la probabilidad de haber aceptado ? Dicho de otra forma ¿qué probabilidad hay de creer que la media sigue siendo 6.50 si en realidad ha aumentado a 6.55? Se trata de calcular la probabilidad de cometer ETII, que consiste en aceptar una que es falsa. A un nivel de significación del 5%, el punto crítico que habíamos encontrado es 6.60, por lo que:

Figura 11.14: Ubicación de los tipos de error de la prueba si es verdadera o si es falsa

La probabilidad de ETII en este caso es el área bajo la curva inferior que está por debajo del punto crítico, 6.60. Para calcular es necesario hallar esa área bajo la curva normal centrada en 6.55, lo que requiere que se lo transforme a puntaje :

Cuya área izquierda asociada es:

## [1] 0.7967306

Éste es el valor de para esta prueba y esta media alternativa. Leemos el resultado diciendo que: “si el verdadero promedio al egreso fuera de 6.55, habría una probabilidad de 0.7967 de creer que sigue siendo igual al histórico, de 6.60”.

Calculamos la potencia de esta prueba, como el complemento de :

Esta potencia es la probabilidad de detectar una diferencia de 0.05 entre la media real y la hipotética (es la diferencia entre 6.50 y 6.55) a un nivel de significación del 5%, con una muestra de 100 observaciones. Estos cuatro elementos: magnitud de la diferencia, tamaño de la muestra, nivel de significación y potencia están vinculados entre sí y deben tenerse en cuenta al planificar un estudio que vaya a usar pruebas de hipótesis.

11.5.1 Curva de potencia

Dado que no se conoce la verdadera media de la población, solo podemos conjeturar acerca de ella y calcular el ETII () y la potencia () para diferentes valores posibles, como hemos hecho para tres valores en el gráfico 11.13. En general, resulta más valioso calcular la potencia () porque nos informa sobre la calidad de la prueba. El cálculo es largo porque deben seguirse los mismos pasos que en el ejemplo anterior para cada una de las medias posibles, pero podemos automatizarlo en una hoja de cálculo. La tabla para calcular la potencia de la prueba anterior se construye manteniendo el punto crítico fijo en 6.60 (y también la desviación estándar y el tamaño de la muestra), y calculando el puntaje correspondiente a ese valor “desde” diferentes medias poblacionales alternativas, a las que hemos llamado . Así resulta:

| Media alternativa | |||

|---|---|---|---|

| 6.51 | 1.50 | 0.9332 | 0.0668 |

| 6.53 | 1.17 | 0.8783 | 0.1217 |

| 6.55 | 0.83 | 0.7977 | 0.2023 |

| 6.57 | 0.50 | 0.6915 | 0.3085 |

| 6.59 | 0.17 | 0.5662 | 0.4338 |

| 6.61 | -0.17 | 0.4338 | 0.5662 |

| 6.63 | -0.50 | 0.3085 | 0.6915 |

| 6.65 | -0.83 | 0.2023 | 0.7977 |

| 6.67 | -1.17 | 0.1217 | 0.8783 |

| 6.69 | -1.50 | 0.0668 | 0.9332 |

| 6.71 | -1.83 | 0.0334 | 0.9666 |

| 6.73 | -2.17 | 0.0151 | 0.9849 |

| 6.75 | -2.50 | 0.0062 | 0.9938 |

| 6.77 | -2.83 | 0.0023 | 0.9977 |

| 6.79 | -3.17 | 0.0008 | 0.9992 |

| 6.81 | -3.50 | 0.0002 | 0.9998 |

| 6.83 | -3.83 | 0.0001 | 0.9999 |

| 6.85 | -4.17 | 0.0000 | 1.0000 |

| 6.87 | -4.50 | 0.0000 | 1.0000 |

Resultan así diferentes valores para la potencia, uno para cada media posible y vemos, ahora numéricamente, como disminuye el riesgo de aceptar a medida que la verdadera media es más lejana. Al mismo tiempo, aumenta la probabilidad de rechazar (aumenta la potencia). Esos resultados se representan gráficamente en lo que se denomina curva de potencia. Para el ejemplo anterior, la curva de potencia es la de la figura 11.15.

Figura 11.15: Curva de potencia con , y

En el eje horizontal se ubican las posibles medias poblacionales (las distintas ) y en el vertical, la potencia asociada a cada una de ellas. Vemos que si la verdadera media es la hipotética (), la probabilidad de rechazarla es , y esa probabilidad aumenta a medida que se consideran medias más lejanas a . Si la verdadera media poblacional fuera tan lejana como 6.90, la probabilidad de rechazar es casi 1, lo que indica que es casi seguro que se rechazará esa hipótesis.

Dijimos antes que la potencia es una medida de la calidad de la prueba, en efecto, cuanto más rápidamente crezca esta curva, tanto más sensible será la prueba, porque será más probable detectar hipótesis nulas que son falsas y rechazarlas. Dicho de otro modo, será alta la probabilidad de rechazar una hipótesis nula si la verdadera media difiere -aunque sea poco-, de la hipotética.

La forma de la curva de potencia depende de varios factores, de los que solo nos detendremos en el tamaño de la muestra. Con muestras más grandes, si todo lo demás se mantiene sin cambios, la potencia de la prueba aumenta. Inversamente, muestras pequeñas reducen la potencia.

Veamos esto gráficamente, si la muestra fuera de menor tamaño que la del ejemplo, como n=50, la curva de potencia es la de la figura 11.16:

Figura 11.16: Curva de potencia con , y

Igual que antes, en 6.50, la probabilidad de rechazo es 0.05, que es . Pero cuando consideramos valores más lejanos de la media poblacional, la curva sube con más lentitud que la anterior, podríamos decir que “tarda más en reaccionar”, son necesarios alejamientos más grandes para que crezca la probabilidad de rechazo.

Por el contrario, si se trata de una muestra de mayor tamaño, como 200 casos, la curva tiene la forma de la figura 11.17:

Figura 11.17: Curva de potencia con , y

Que muestra un aumento más rápido de la probabilidad de rechazar una cuando ésta es falsa.

Es importante destacar que la potencia no depende del resultado observado en la muestra, por el contrario, es un indicador de la calidad de la prueba como tal, independientemente de lo que se encuentre en la muestra. Por esta razón, el análisis de la potencia se realiza al momento de planificar un experimento. Tiene mucha importancia para calcular el tamaño de muestra necesario para detectar una determinada diferencia entre grupos.

Existen índices para estandarizar la distancia entre el verdadero valor del parámetro y el hipotético. Esos índices permiten comparar entre pruebas de diferente naturaleza (porque están estandarizados), se denominan medidas del tamaño del efecto. Ellis (2010) provee un tratamiento detallado de este tema, en el apéndice regresaremos sobre ellas.

11.5.2 Significación estadística y valor

Hasta este punto se ha indicado que el equipo de investigación establece el nivel de significación estadística al realizar una prueba de hipótesis, a partir de lo cual se determinan zonas de rechazo y no rechazo de la hipótesis nula y que esto puede hacerse sobre valores estandarizados o del estimador. Luego, una vez obtenido el resultado de la muestra, se indica en qué zona se ubica, y se decide si se acepta o rechaza la . La forma en que se comunican los resultados es, por ejemplo: “se rechaza la a un nivel del 5%”. De modo que, como hemos dicho, se establece una regla de decisión y en base a ella se decide por sí o por no.

En una prueba unilateral derecha al 5%, el puntaje que determina el punto de corte entre las zonas de rechazo y no rechazo es , por lo que, si se obtiene un , se rechaza y también se rechaza si se obtiene , porque ambos son superiores al punto crítico. Sin embargo, encontrar indica que el valor observado se aleja en gran magnitud del hipotético, mientras que si , se rechaza más cerca del límite. Entre dos situaciones, que ambas llevan a rechazar , puede haber diferencias de importancia; por eso es necesaria una medida de la magnitud de la diferencia. Para ver esto gráficamente, se denomina y a dos puntajes obtenidos de la estandarización de los resultados de dos observaciones diferentes:

Figura 11.18: Ejemplo de dos valores posibles de que conducen a rechazar

Aunque los dos valores de llevan a concluir que se debe rechazar la (porque ambos están en la zona de rechazo), el valor es sustancialmente menos probable que el , por lo que podríamos decir que en ese caso () tenemos más evidencia para rechazar , sin embargo, si solo informamos que “se rechaza a un nivel del 5%”, quien lee no puede saber si se trató de una diferencia grande o pequeña.

El modo en que se transmite esta información es ofreciendo el valor de probabilidad asociado al resultado muestral, que también se llama valor . Se trata de la probabilidad de observar en la experiencia un resultado igual o más extremo que el obtenido a partir de los datos muestrales, bajo el supuesto de que la hipótesis nula es cierta. Es decir, la probabilidad de hallar un resultado como el que se encontró o más extremo que él, solo por azar. Un valor pequeño indica que el resultado observado (o resultados más extremos que él) son poco probables bajo el supuesto de hipótesis nula cierta, por lo cual hay evidencia en contra de la hipótesis nula.

El valor es una probabilidad condicional a la que escribimos formalmente como:

Donde es el estimador del parámetro al que se refiere la . La expresión es la forma reducida de decir que sea más extrema (por encima o por debajo) que el valor observado.

Cuanto más pequeño es el valor , tanta más evidencia hay para rechazar . Por el contrario, un valor grande indica que el resultado observado es muy probable bajo el supuesto de hipótesis nula cierta, lo que no aporta evidencia en contra de la hipótesis nula y conduce a no rechazarla. El uso del valor es más cercano al enfoque original de Fisher, el cual, a diferencia del de Neyman y Pearson, no establece un punto de corte para tomar una decisión dicotómica, sino que mide la “fuerza de la evidencia” en contra de por medio de una probabilidad. Pero esa probabilidad no está asociada a , lo cual es un error de interpretación frecuente, sino a los valores muestrales.

Esta manera de indicar cuán esperable sería lo que hemos observado si fuera cierta, puede vincularse con el razonamiento anterior, comparando el valor con el nivel de significación fijado de antemano. Así resultan dos posibilidades:

Si el valor es menor que el nivel de significación establecido (): se rechaza la hipótesis nula y se describe como “un resultado estadísticamente significativo”. Esto quiere decir que la probabilidad de haber hallado este resultado por azar es pequeña, por lo que se trata de un efecto o diferencia que muy difícilmente se puede atribuir al azar.

Si el valor es mayor que el nivel de significación establecido (): no se rechaza la hipótesis nula y se expresa como “un resultado no estadísticamente significativo”. Lo que expresa que la probabilidad de haber hallado este resultado por azar es mayor que el máximo establecido, por lo que es razonable atribuirlo al azar, es decir a la variabilidad propia de los resultados muestrales.

Es decir, se trata de dicotomizar el continuo del campo de variación de , que es a que sea mayor o menor que .

Pero aun cuando esta modalidad de presentar el resultado puede hacerse

equivalente a la toma de decisión por sí o por no, constituye un aporte importante de información, porque pasa de la conclusión

dicotómica (se rechaza o no se rechaza) a la probabilidad de hallar este resultado si la hipótesis nula fuera cierta.

A continuación calculamos estas probabilidades en los ejemplos vistos, empezando por pruebas unilaterales:

En el ejemplo sobre el promedio al egreso de una carrera universitaria: